掃二維碼與項目經理溝通

我(wǒ)(wǒ)們在微信上24小(xiǎo)時期待你的聲音

解答本文疑問/技術咨詢/運營咨詢/技術建議/互聯網交流

自然語言處理( Natural Language Processing, NLP)是計算機科學領域與人工(gōng)智能領域中(zhōng)的一(yī)個重要方向。它研究能實現人與計算機之間用自然語言進行有效通信的各種理論和方法。

一(yī)、文本分(fēn)類

技術思想及原理分(fēn)析

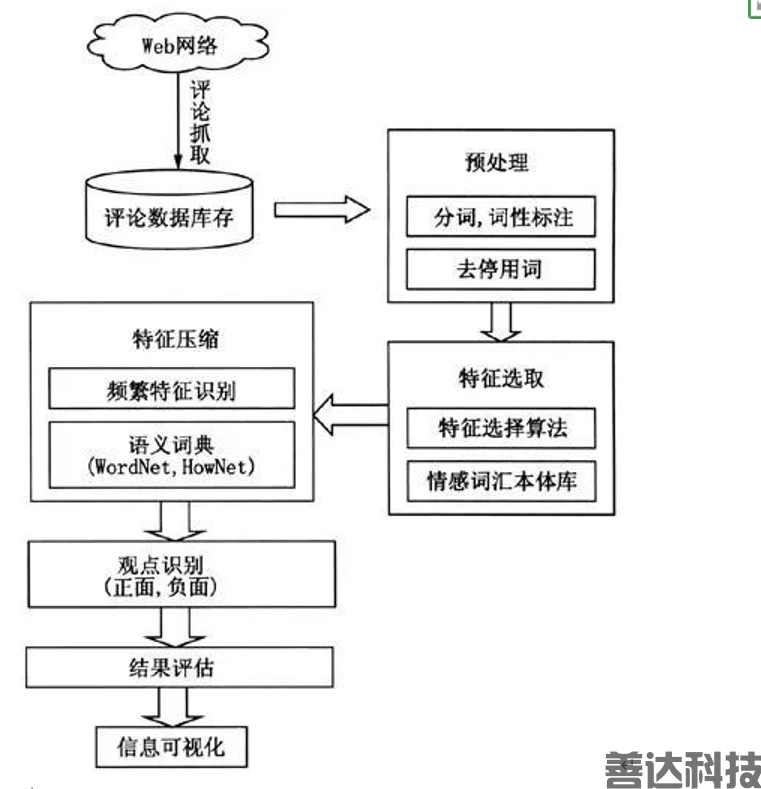

文本分(fēn)類就是對一(yī)段話(huà)進行區分(fēn)是哪個類别,比如一(yī)篇新聞所屬的行業類别、一(yī)段文字的情感分(fēn)析、一(yī)段評論的結果傾向等,都屬于對文本的分(fēn)類。文本分(fēn)類是先對同一(yī)類别的文本打上相同的标簽,然後讓模型去(qù)學習針對不同類别的文本特征。當模型學習到了每個類别的特征後,在使用過程當中(zhōng),就可以對不同類别的文本進行分(fēn)類了。在對文本進行分(fēn)類訓練之前,先要對文本進行分(fēn)詞處理,然後讓模型學習各個詞之間的關系,最後根據每個詞的詞向量組合形成句向量,段向量,最後是一(yī)篇文章的向量,這篇文章的向量經過轉化就是最終所屬的類别。

應用場景及商(shāng)業價值

文本分(fēn)類模型應用有很多細分(fēn)領域,比如情感傾向分(fēn)析、情緒類别判斷、文章類型分(fēn)類、評論區留言分(fēn)類判斷等。有了文本分(fēn)類模型,很多原來需要人工(gōng)分(fēn)類判斷的文本信息就可以由AI來完成了,不但大(dà)大(dà)節約了人力成本,還降低了使用門檻,讓原來隻有專業人士才能做的工(gōng)作,有了AI文本分(fēn)類模型的輔助,普通人也能夠做了。

二、文章摘要

技術思想及原理分(fēn)析

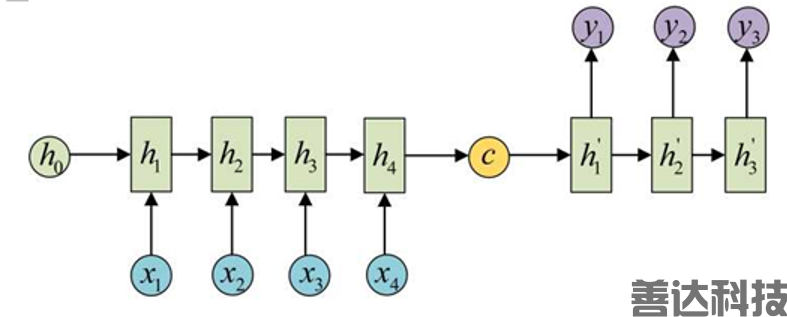

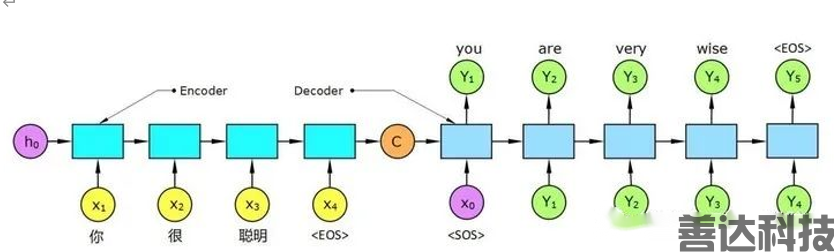

文章摘要就是輸入一(yī)篇文章,然後讓模型去(qù)理解這篇文章的内容含義,最後根據整體(tǐ)内容提煉出關鍵的信息做爲這篇文章的摘要信息。很明顯,模型的輸入是一(yī)篇字數較多的文章,而模型的輸出則是一(yī)段字數簡短的摘要信息。也就是輸入端和輸出端的的字數長度都是不确定的。使用神經網絡的方法就需要創建一(yī)個輸入和輸出長度都不一(yī)樣的模型來實現。而語言模型的輸入語料前後之間都是有關聯的。基于循環神經網絡RNN的複合變種模型SEQ2SEQ是比較适合來解決此類問題的。在SEQ2SEQ的模型中(zhōng),主幹網絡可以是RNN,也可以是GRU、SRU等模型。下(xià)面是輸入和輸出長度都不一(yī)樣的SEQ2SEQ模型,輸入爲4個值,輸出爲3個值。

應用場景及商(shāng)業價值

文本摘要的主要應用在新聞行業較廣泛,可快速對一(yī)些新聞提取重要觀點内容,根據提取的觀點内容進行分(fēn)門别類,或者利用對新聞提取到的新聞觀點,做爲新聞概要展示或者做爲讀者快速閱讀部分(fēn)。對于其他類型的文章,也可以根據提取到的文章摘要來判斷文章的觀點等内容。

三、閱讀理解

技術思想及原理分(fēn)析

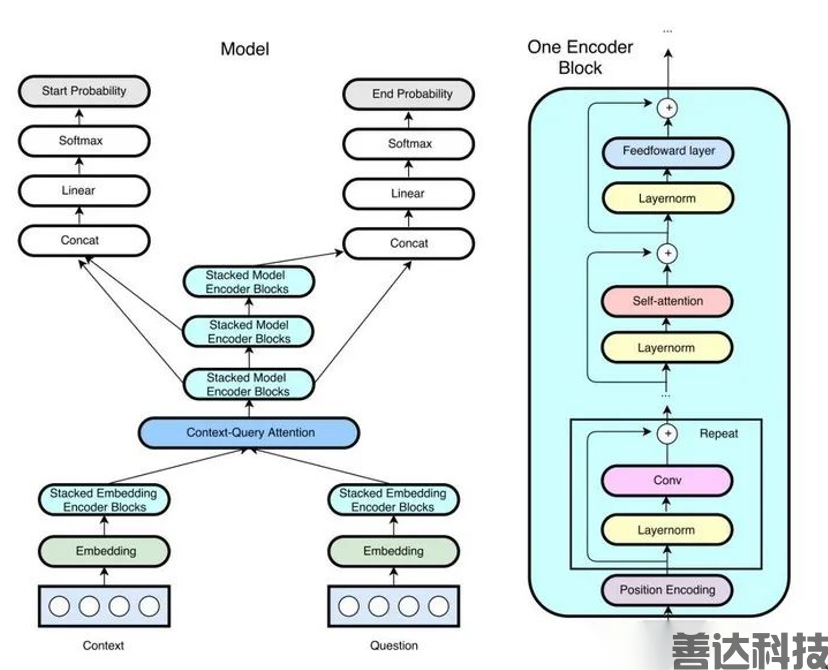

閱讀理解和前面所講的文章摘要剛好相反,文章摘要是把長篇文章内容壓縮成簡短的概要,以供讀者快速閱讀或者分(fēn)辨;而閱讀理解是根據文章中(zhōng)的某段話(huà),提出自己的理解。一(yī)篇文章中(zhōng)的一(yī)句話(huà)很短,但是在閱讀理解中(zhōng)卻要花費(fèi)較長的語句來描述,比如文章中(zhōng)說了一(yī)句話(huà),要理解這句話(huà)的引申義,就需要更多的文字來描述,所以閱讀理解輸入是較短的語句,輸出則是較長的語句。閱讀理解對于模型的難度往往比文章摘要高的多,其主要原因就是一(yī)句話(huà)的語境不同,其要表達的含義也不同,所以要理解文章中(zhōng)某句具有特殊含義的話(huà),需要進入文章中(zhōng)的相關前後文去(qù)理解才行,甚至很多模型需要加入注意力機制來更好的理解語句的含義。閱讀理解的深度學習模型有BIDAF、R-Net、QANet以及目前在語言模型較火(huǒ)的transformer、Bert、GPT系列等。下(xià)面展示的是QANet模型的結構。

應用場景及商(shāng)業價值

閱讀理解的應用範圍非常之廣,可以說如果AI真正的掌握了閱讀理解,也就實現了真正意義上的認知(zhī)智能。目前AI在閱讀理解方面學到的知(zhī)識非常有限,隻能做一(yī)些基本的理解,無法做到像人類一(yī)樣,能夠理解到同樣的語言子啊不同的語境下(xià)的含義,不過随着AI的發展,尤其是以深度學習爲主的模型的快速發展,相信不久就能夠看到和人類閱讀理解能力相當的智能産品了。

四、智能對話(huà)

技術思想及原理分(fēn)析

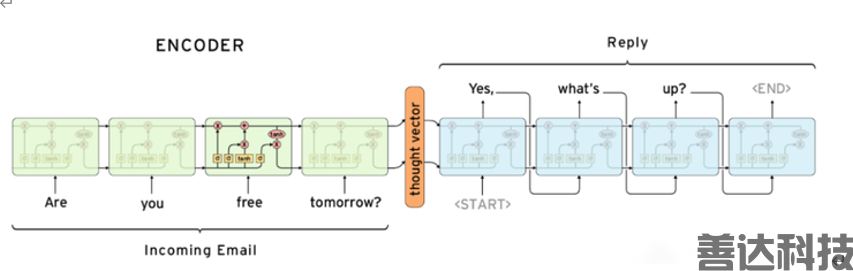

智能對話(huà)就是人類和機器對話(huà),可以是問答形式,也可以是聊天的形式,常用的技術主要有以RNN爲基礎的SEQ2SEQ模型,其原理是通過對提問者發的的語言詞向量進行學習,輸出對應的答案爲标簽。通過大(dà)量語料庫的學習,讓模型具備一(yī)定的對話(huà)能力。目前的對話(huà)模型基本都能夠回答某特定領域的問題,比如行業客服機器人、生(shēng)活聊天機器人等。下(xià)圖是一(yī)個簡單SEQ2SEQ的對話(huà)模型。

應用場景及商(shāng)業價值

對話(huà)模型的應用産品最爲常見,比如電(diàn)商(shāng)的客服機器人、地圖AI助手、微軟小(xiǎo)娜等,都屬于對話(huà)模型的産品,對話(huà)可以是文字形式的,也可以是語音形式的,如果是語音的形式的對話(huà),就不僅僅是自然語言領域了,還要涵蓋語音識别方向了。電(diàn)商(shāng)平台的智能客服的主要作用是幫助平台提高服務效率,降低人工(gōng)成本。其他平台的産品大(dà)多也都是爲了提高服務體(tǐ)驗。所以目前的智能對話(huà)模型基本都是工(gōng)具類的應用,生(shēng)活類的對話(huà)模型難度比較大(dà),因爲生(shēng)活中(zhōng)的語料數據是非常龐大(dà)的,不像工(gōng)具類的語料數據較小(xiǎo),很容易學習。一(yī)個真正意義上的對話(huà)機器人是要将閱讀理解學習到位的模型才可以的。

五、機器翻譯

技術思想及原理分(fēn)析

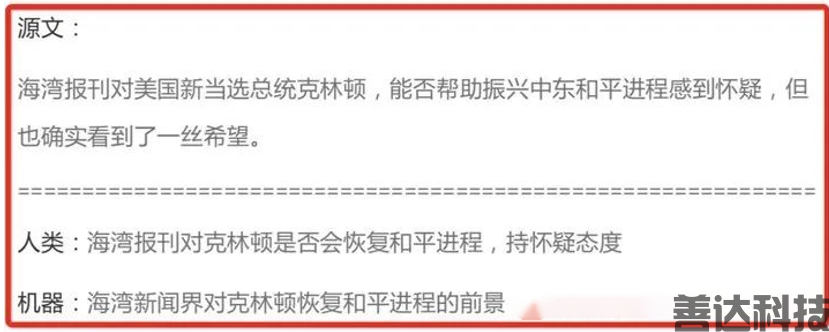

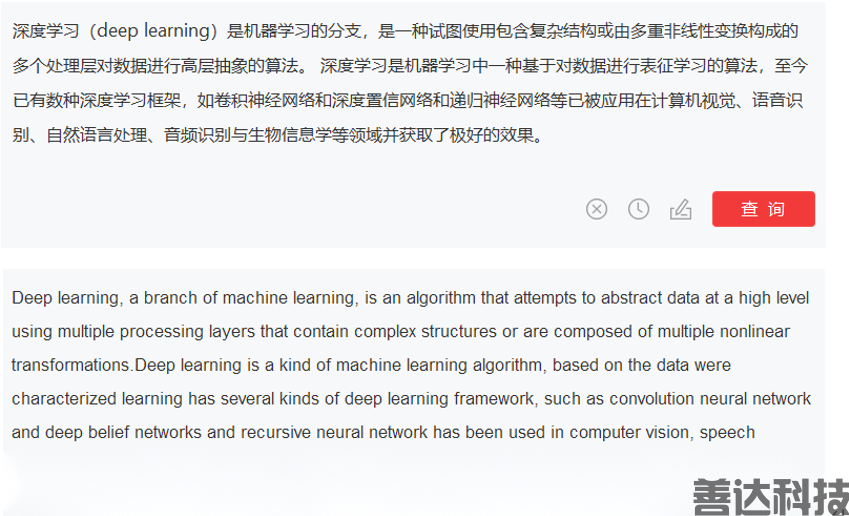

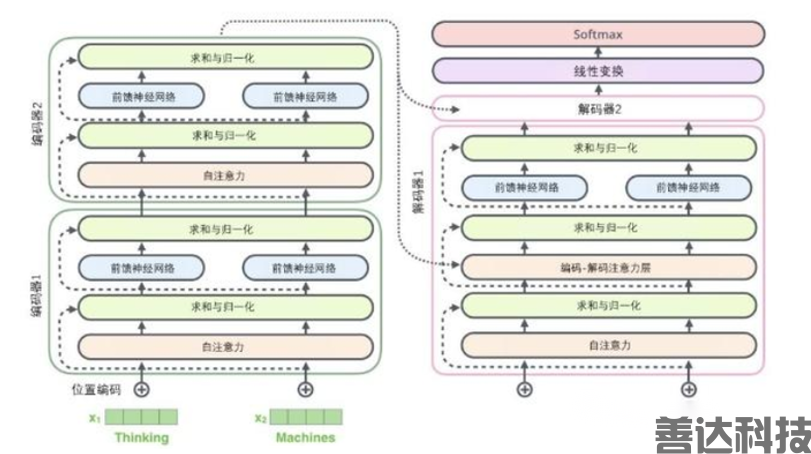

機器翻譯原理上和對話(huà)模型一(yī)樣,隻不過對話(huà)模型要提取的特征是一(yī)句話(huà)的邏輯語義信息,用來預測後面語句的輸出概率。翻譯模型是在提取一(yī)句話(huà)的語義信息後,對應的不是後面的語句,對應的另一(yī)種表達形式,也就是新的一(yī)種語言的表達形式。比如英文翻譯成中(zhōng)文,就是先将一(yī)句話(huà)的英語表達提取成中(zhōng)間向量特征,然後再将中(zhōng)間的向量特征翻譯成對應的中(zhōng)文。其應用較爲廣泛的模型以帶了注意力機制的編解碼模型SEQ2SEQ爲主。下(xià)圖就是SEQ2SEQ的語言翻譯模型。

應用場景及商(shāng)業價值

翻譯模型的應用在生(shēng)活和工(gōng)作中(zhōng)都很常見,其主要價值就是對一(yī)些要求不是非常高的翻譯,使用機器來翻譯,能夠提高翻譯效率,降低人工(gōng)成本。比如谷歌網站上的自動翻譯、以及國内的很多自動翻譯的工(gōng)具都是機器翻譯,很多時候直接使用機器翻譯,會有一(yī)些誤差。尤其是對某些專業領域的專業詞的翻譯偏差還是較大(dà)的。和對話(huà)模型一(yī)樣,想要讓機器翻譯做的和人工(gōng)翻譯一(yī)樣,必須要達到讓模型理解語境才可以。

六、文本生(shēng)成

技術思想及原理分(fēn)析

文本生(shēng)成是一(yī)種創造性的工(gōng)作,比如讓神經網絡寫一(yī)篇文章,寫一(yī)首詩詞等,都算是文本生(shēng)成類的任務。文本生(shēng)成模型通過學習大(dà)量的某類型的語料數據就可以生(shēng)成這一(yī)類别的文章,目前流行的文本生(shēng)成類模型還是以transformer、Bert、GPT以及他們的一(yī)些變種模型爲主。其難度是由于模型通過不斷的堆疊編碼器和解碼器導緻其參數越來越多,對算力要求也越來越大(dà),不利于小(xiǎo)型設備訓練和使用。下(xià)圖是transformer模型的結構圖,一(yī)個較小(xiǎo)的模型就有6個編碼器和6個解碼器堆疊而成,而每個編碼器和解碼器并不是卷積模型,全都是全連接模型,這導緻了參數量進一(yī)步的增大(dà)。

應用場景及商(shāng)業價值

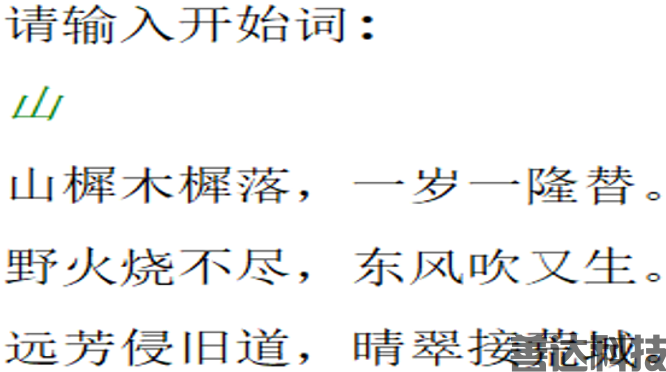

文本生(shēng)成主要可以用來寫文章,自動生(shēng)成新聞,自媒體(tǐ)軟文等,其應用範圍非常廣泛,但是想要達到好的效果,還是要更大(dà)的模型才能完成的。如果受限于設備的算力,無法使用較大(dà)的模型來訓練,可以考慮雲算力來提高訓練效率。下(xià)面是訓練了十幾首唐詩,來自動生(shēng)成詩詞的GPT2的模型,可以看到,由于數據量較小(xiǎo),模型學習到的字數也不多,隻能從很小(xiǎo)的可學習的字庫中(zhōng)拼湊,詩詞效果也就一(yī)般。

我(wǒ)(wǒ)們在微信上24小(xiǎo)時期待你的聲音

解答本文疑問/技術咨詢/運營咨詢/技術建議/互聯網交流